-

transformers

基础 常见处理任务 情感分析 文本生成 阅读理解 机器翻译 特征提取 对话机器人等 相关库 核心库 分词器 数据集库 评估函数 微调 分布式训练 加速库 可视化部署库 pipeline 数据预处理 模型调用 结果后处理组成的流水线 支持很多任务 导入SUPPORTED_TASK可以查看支持的任务 from pprint import pprint pprint(SUPPORTED_TASKS.ke…- 20

- 0

-

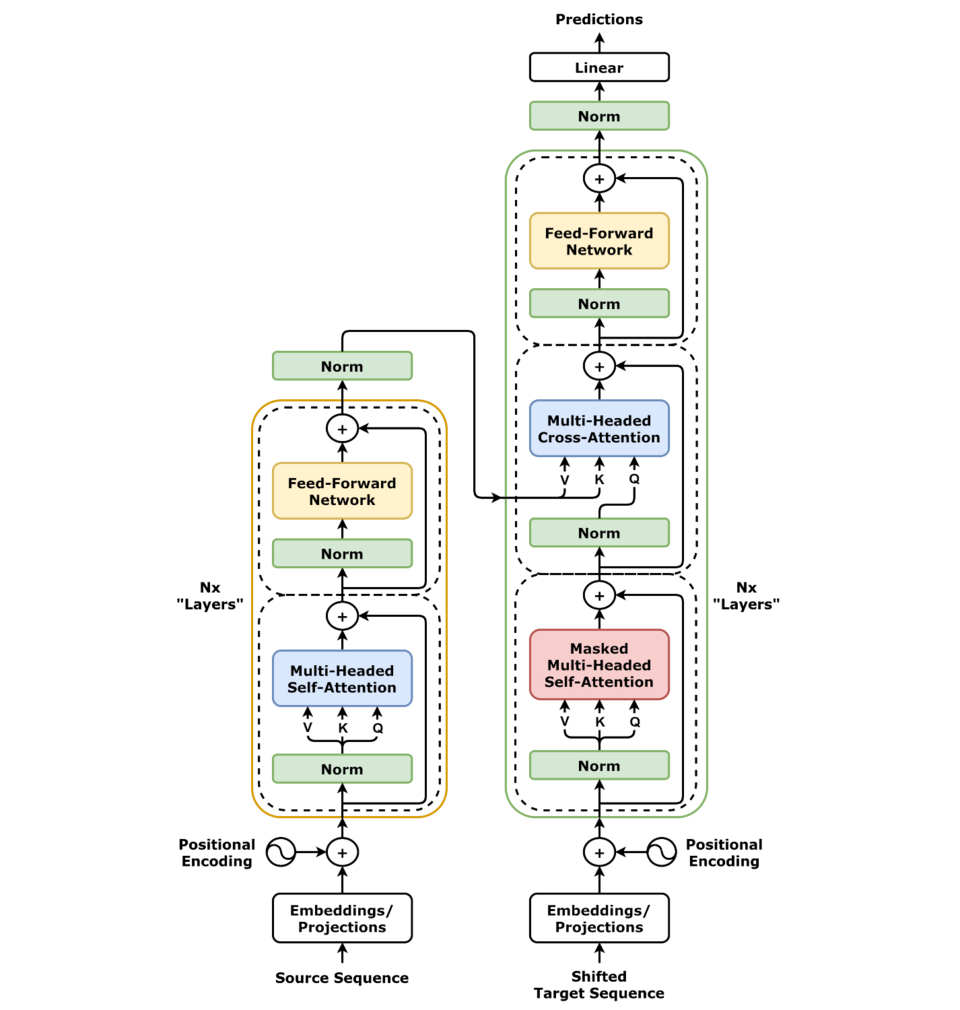

transformer

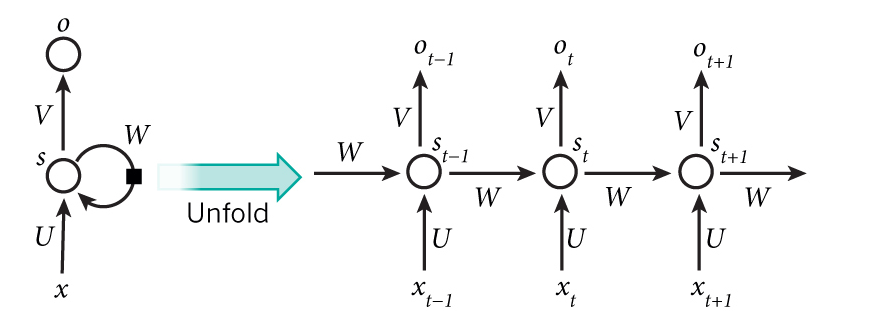

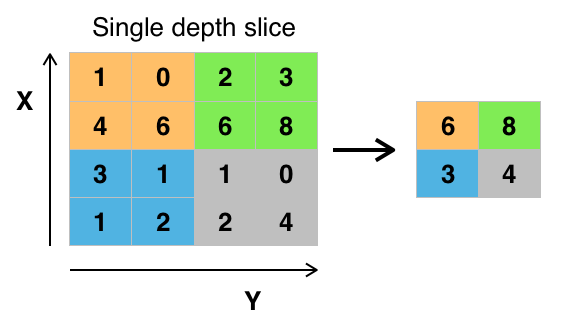

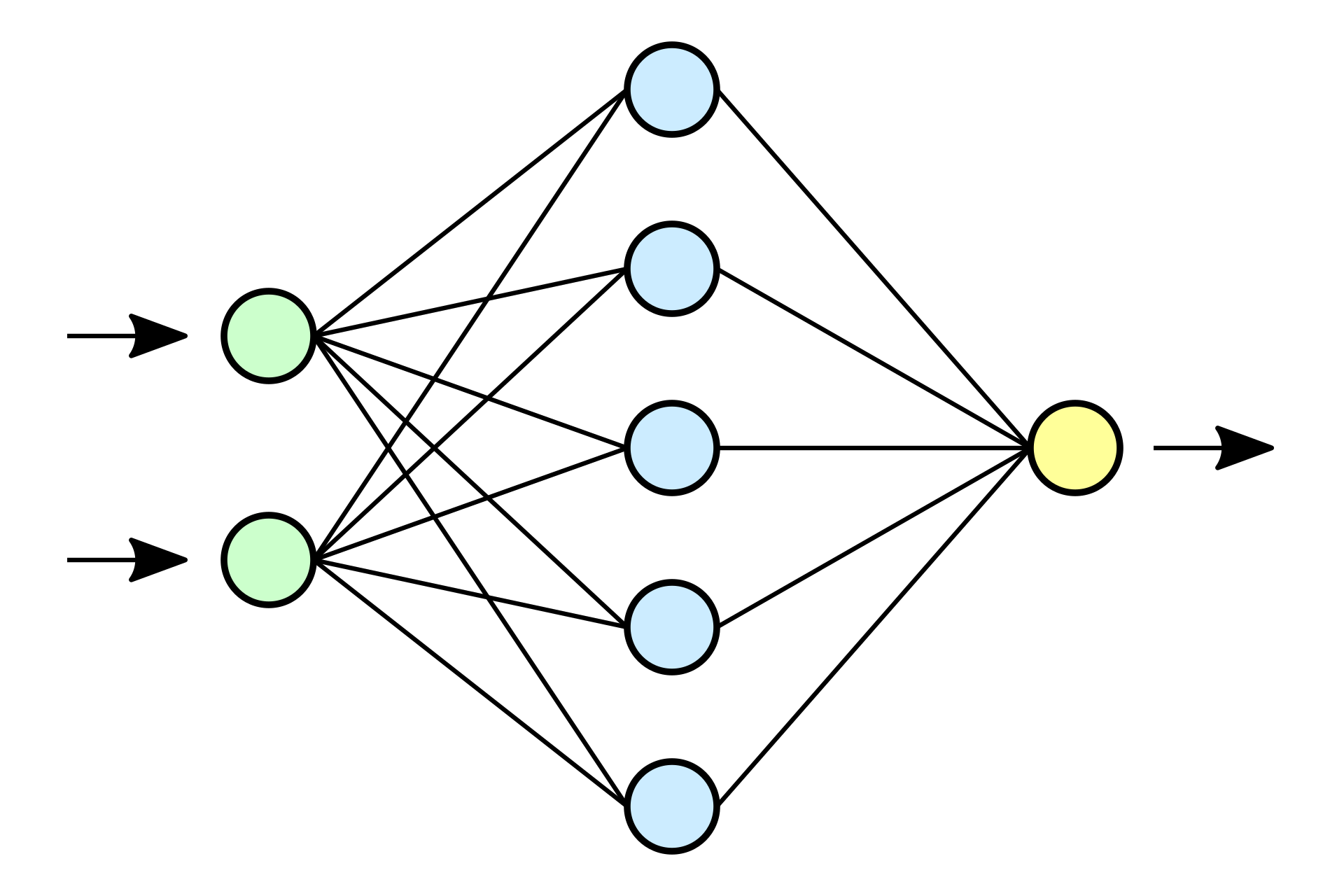

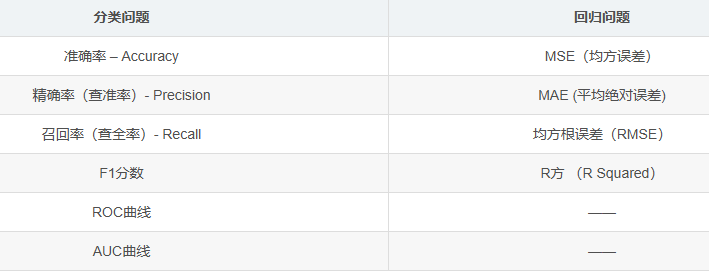

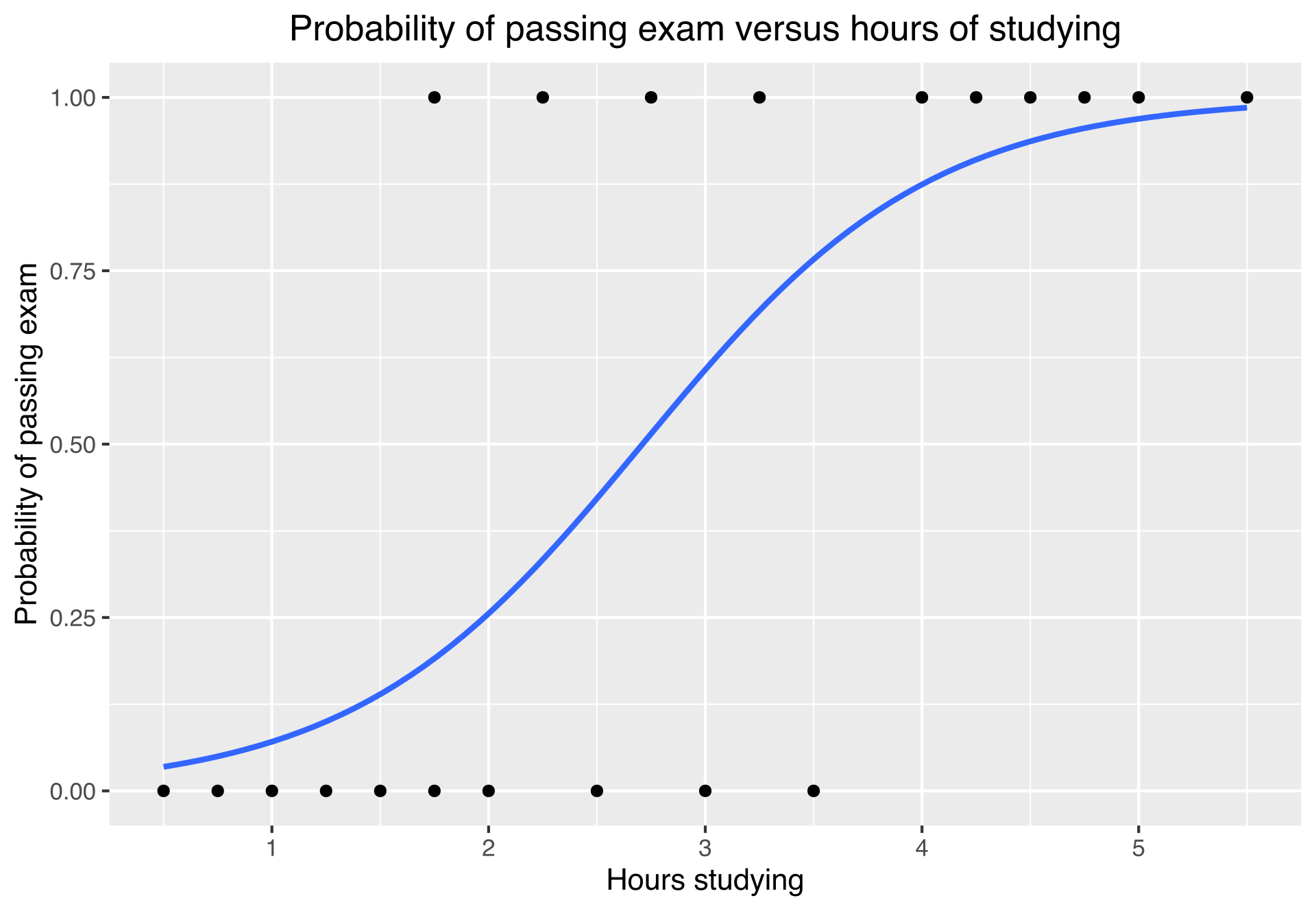

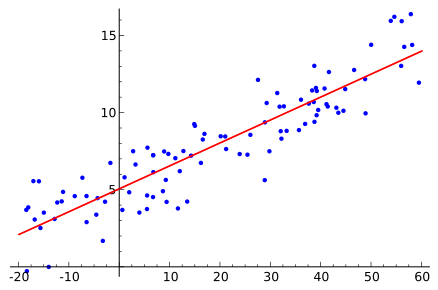

发展史 谷歌用来翻译,编码解码 文字数字化,位置向量化,语义关系化,预测概率化 llama-2-70b 140g文件 700亿参数(10tb数据集,6000显卡训练12天,200w美元) 实现原理:返回之前所有输入预测下一次字的概率(反复) 原理 1、tokenization 文字转数字 input->token vocab_size(常用tiktoken)总共的token 2、位置信息编码…- 36

- 0

❯

搜索

扫码打开当前页

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

Z优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!